Les personnes en situation de handicap, et de manière encore plus importante les femmes en situation de handicap, sont souvent confrontées à des stigmatisations et des préjugés persistants, ce qui entraîne des discriminations dans plusieurs sphères de la vie, notamment dans l’accès à l’emploi. L’introduction de l’intelligence artificielle (IA) dans les procédures de recrutement a été adoptée par certaines entreprises comme une réponse aux préjugés et biais présents dans les choix des candidat·e·s et ainsi garantir une sélection plus objective et équitable à l’embauche.

L’IA dans les processus de recrutement : que des avantages ?

L’IA offre, en théorie, la possibilité d’une évaluation objective des compétences et qualifications des candidat·e·s sans tenir compte d’autres facteurs tels que le handicap et le genre. Elle peut aussi faciliter l’adaptation des lieux de travail en identifiant rapidement les besoins spécifiques et en suggérant des aménagements raisonnables.

Cependant, malgré son potentiel pour éliminer les biais humains, l’IA peut paradoxalement perpétuer et amplifier ces discriminations, notamment envers les femmes en situation de handicap.

L’IA est une technologie qui permet à des machines d’apprendre à penser et à agir comme des personnes. Elle peut créer des biais, car elle reflète les préjugés de la société à travers les données qui la nourrissent. Si ces données sont biaisées ou discriminatoires, l’IA reproduira ces inégalités. De plus, l’IA est souvent développée par des équipes peu diversifiées, principalement composées d’hommes blancs, cisgenres et valides. Cela peut renforcer un manque de sensibilité aux besoins des groupes plus vulnérables, comme les femmes ou les personnes en situation de handicap.

Plusieurs défis et risques persistent et peuvent accentuer les discriminations déjà présentes dans le domaine de l’emploi et ainsi y entraver l’inclusion des femmes en situation de handicap.

Risque de reproduction des inégalités et discriminations

L’un des plus grands défis posés par l’IA dans le recrutement est la reproduction des biais existants, qui affectent souvent les groupes déjà marginalisés, notamment les femmes et les personnes en situation de handicap. Les algorithmes, s’ils sont entraînés avec des données biaisées, peuvent involontairement renforcer ces inégalités. D’autre part, l’IA pourrait également permettre une discrimination volontaire dans le recrutement dans l’entreprise. Les développeuses·eurs pourraient délibérément manipuler les critères de sélection pour favoriser ou exclure certaines caractéristiques personnelles telles que l’âge, le genre ou encore l’origine ethnique. Les algorithmes d’IA peuvent donc théoriquement être programmés pour discriminer. Citons notamment le cas d’Adecco en France qui a utilisé un système de fichage racial ! Une entreprise pourrait aussi programmer un algorithme pour privilégier les candidat·e·s qui ne demandent pas des aménagements adaptés, ce qui pourrait exclure les femmes en situation de handicap qui en ont besoin.

Les données utilisées pour développer ces algorithmes sont encore trop souvent biaisées, reflétant les stéréotypes et les discriminations envers les personnes en situation de handicap que ces dernières rencontrent déjà au quotidien. De plus, des phases clés du recrutement, notamment le tri des CV et les entretiens virtuels, posent des défis supplémentaires pour les candidat·e·s en situation de handicap, augmenté par les biais algorithmiques.

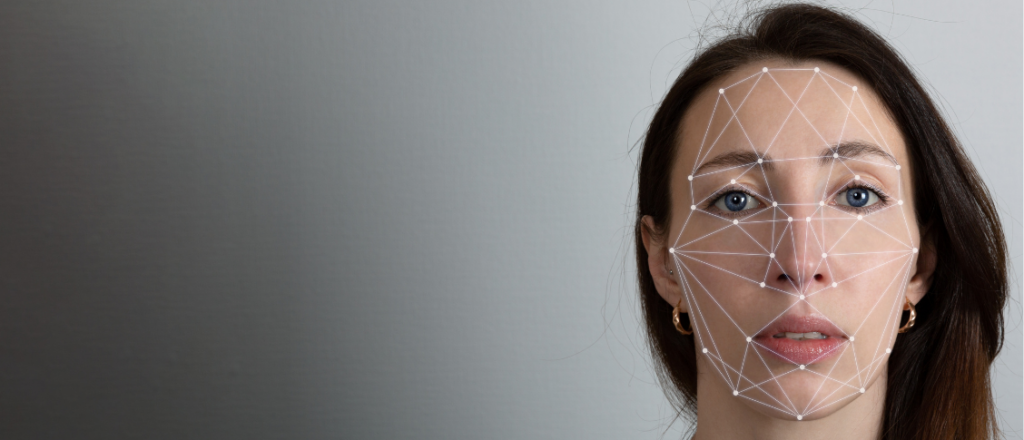

Les algorithmes de tri des CV ou de présélection peuvent être discriminatoires et exclure involontairement les femmes en situation de handicap si les critères utilisés ne tiennent pas compte de la diversité de leurs compétences, leurs qualifications et leurs expériences. L’utilisation de la reconnaissance vocale et faciale lors des entretiens virtuels peut exclure involontairement les candidat·e·s ayant des troubles de la parole ou des expressions faciales atypiques. Les plateformes utilisées pour les entretiens virtuels peuvent également ne pas être accessibles à tout le monde. L’IA permet par ailleurs aussi aux employeuses·eurs d’interviewer les candidat·e·s à travers des vidéos qui pourraient être analysées par des algorithmes. L’analyse des émotions par l’IA dans les entretiens en vidéo pose également des problèmes d’équité et d’inclusion. Les personnes ayant des troubles neurologiques ou des difficultés d’expression émotionnelle peuvent présenter des signaux non verbaux différents ou moins perceptibles qui pourraient être mal interprétés par les algorithmes.

Comment atténuer les biais et promouvoir l’égalité ?

Pour réduire les discriminations, il est impératif de diversifier les données d’entraînement, d’impliquer directement les personnes concernées dans le développement des algorithmes de recrutement, de former les développeuses·eurs à reconnaître et à réduire les biais et de sensibiliser les professionnel·le·s RH aux défis spécifiques rencontrés par les personnes en situation de handicap.

De plus, il est essentiel de reconnaître que l’innovation de l’IA ne peut être véritablement inclusive que si elle est accessible à toutes et tous. L’intégration de l’IA dans le recrutement offre des opportunités importantes pour favoriser l’inclusion et l’équité, mais uniquement si elle est mise en oeuvre de manière réfléchie et éthique afin de garantir le fait que tous les individus aient des opportunités égales sur le marché du travail. L’utilisation de l’IA par des entreprises dans le recrutement, notamment dans le secteur public, demande beaucoup de précautions et de garantie sur la protection des droits des employé·e·s. Cela pourrait par exemple se faire à travers la mise en place des comités d’accompagnement éthiques. Ces comités pourraient évaluer les pratiques de recrutement basées sur l’IA et les actions pour lutter contre les discriminations volontaires ou involontaires.